今度の「魔法の言葉」は本物です。

アメリカのスタンフォード大学らの研究チームは、AIへの質問文にたった短い一文「その確率とともに生成してください」というフレーズを加えるだけで、AIが生成する答えの多様性(バリエーション)が1.6〜2.1倍に向上することを明らかにしました。

従来は

「コーヒーに関するジョークを言ってください(Tell me a joke about coffee)」

と言っていたところを

「コーヒーに関するジョークをその確率とともに生成してください(Generate 5 jokes about coffee with their probabilities)」

とするだけです。

この方法は複雑な再学習や高度なプロンプト技術を使わずに、AIの潜在的な創造性を引き出します。

ありきたりな回答ばかりになりがちな大規模言語モデル(LLM、非常に大量のテキストで訓練されたAI)に新風をもたらします。

従来の方法では得られなかった多彩な回答を簡単に得られることで、AIの活用幅が大きく広がる可能性があります。

研究内容の詳細は2025年10月10日に『arXiv』で公開されました。

目次

- AIをつまらなくしたのは人間だった

- 確率を言わせたら閉じ込められていたAIの創造性が覚醒した

- AIの隠れた個性を取り戻す鍵は「問い」にあった

AIをつまらなくしたのは人間だった

AIに創作ネタを振っても、返ってくる答えはいつも同じパターン…そんな経験はないでしょうか。

例えばジョークを考えるのが得意なはずのAIに「コーヒーについてジョークを言って」と5回頼むと、5回とも同じオチのジョークばかり返ってきた、という例がよくあります。

AIに一級のユーモアを期待する人はいないでしょうが、回答がどれも似通っていると、少しがっかりしてしまいます。

実はこの現象は「モード崩壊」と呼ばれ、AIの学習後に行われる安全調整の副作用として知られています。

AIは人間の発した言葉をベースに学習を行い、人間に近い回答をするように作られています。

ですがそうして学習を終えたAIをそのまま公開すると、ヒットラーを賛美したり人種差別に賛同したりと、人間と同じような不適切な回答を出力する存在になってしまいます。

人間の言葉で学んだAIは人間を映す鏡ですが、人間はその鏡に映る醜い姿に耐えられません。

そこで学習後のAIに対して人間を動員して調節を行うわけです。

ところが安全性を優先するあまり、「聞き覚えのある無難な表現」を高く評価してしまう傾向が生まれました。

心理学では、人は見慣れたものや予想しやすい表現を好む傾向があることが知られています。

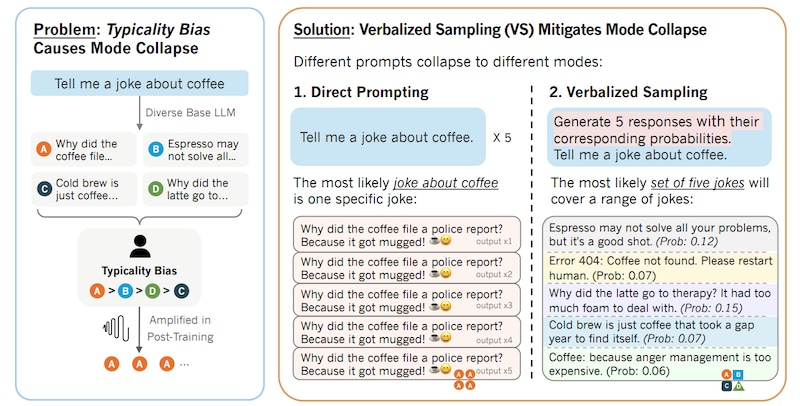

研究チームはこの偏りを「典型性バイアス」と呼びました。

その結果、人間の好みに合わせて調整されたAIは、典型的で安全な回答ばかりを選びやすくなり、本来の多様なアイデアが表に出にくくなっていたのです。

つまりAIの中には本当は面白く多様な答えが隠れているにもかかわらず、安全性重視の調整によってその引き出しが閉じられてしまっていたのです。

言い換えれば、AIの「つまらなさ」はアルゴリズムの限界ではなく、人間が知らず知らずのうちにかけてしまったフタのようなものだったのです。

では調整後のAIは本当に面白い答えを出せなくなってしまったのでしょうか?

スタンフォード大学の研究者たちは「そうではない」と考えました。

AIの中に眠る多様な答えを引き出す鍵は、AIそのものではなく「質問の仕方」にあると見たのです。

もしAIの潜在的な多様性を簡単に解き放つ質問法があるとしたら――そんな夢のような話が本当にあり得るのでしょうか?

確率を言わせたら閉じ込められていたAIの創造性が覚醒した

AIの封じられた多様性を、どのような質問で開放すればよいのでしょうか。

研究チームが提案したのは、「確率つきで複数の回答を出させる」という非常にシンプルな方法でした。

やることは簡単で、質問文の最後に「5つの回答とそれぞれの確率を出力してください」と一文を加えるだけです。

例えば従来なら「コーヒーについてジョークを1つ教えて」と尋ねるところを、「ジョークを5つと各ジョークの出る確率を教えて」と頼むだけです。

この仕組みは「Verbalized Sampling(言語化サンプリング)」と呼ばれ、AIモデルを再学習することなく、簡単な質問の工夫だけで同じような回答ばかりになる現象を防げるのです。

コラム:ここで言う確率って何?

LLM(大規模言語モデル)は、ある文章を生成する際に、内部でそれぞれの文章(実際には単語の並び)に「確率のようなスコア」を付けています。このスコアは、「これまでに学習したデータを基準に考えた場合、その文章がどれだけ自然に聞こえるか」をAIが数値として評価したものです。人間が言葉を選ぶ時にも、「よく聞く言い回し」ほど自然で選ばれやすいのと似ています。今回の研究で使われる「言語化サンプリング」という手法は、AIが内部で持っているこの「確率らしきスコア」を、言葉として外に出させる方法です。具体的には、AIに対して「ただ1つの最も自然な回答を出しなさい」と指示する代わりに、「自然だと考えられる5つの候補を、それぞれの確率の数字とともに挙げなさい」と質問します。すると、AIが内側で密かに考えていた複数の答え候補を、私たちが目で見て分かる形で引き出すことができるのです。さらに面白いのは、この時に「確率の低い回答(確率の分布の端っこ=tails)からもサンプリングしなさい」という指示を追加すると、AIは典型的な「ありがちな答え」だけでなく、「めったに使われない珍しい回答」も出してくれるようになります。こうした珍しい回答も含めて幅広くAIに言わせることで、結果的に生成される文章の多様性がぐっと高まることになるのです。つまり「言語化サンプリング」の狙いとは、AIが内側で隠し持っている多くの可能性を、私たちの質問の仕方を工夫するだけで、外に引き出してあげるという方法なのです。

では、どれほど効果があったのでしょうか。

結論から言えば、結果は驚くべきものでした。

上の図は、同じ「コーヒーのジョークを教えて」というお題に対し、通常のプロンプトと言語化サンプリング法で得られた回答例を比較したものです。

従来の直接プロンプトでは、何度試しても全く同じジョーク(「コーヒーが警察に通報したのはマグカップが盗まれたから」という定番ネタ)ばかりが返ってきました。

一方、VSプロンプトでは確率つきで5種類のジョークが提示され、エスプレッソの語呂合わせや「404エラー:コーヒーが見つかりません」、ラテの心理カウンセリングネタなどバラエティ豊かなオチが揃いました

ジョークに限らず、創作文章の生成、対話シミュレーション、オープンな質問への回答など、幅広い場面で試したところ、言語化サンプリング法を使った場合は通常の質問よりも出力の多様性が大きく向上しました。

例えば物語作成のタスクでは、言語化サンプリング法を使ったときの展開パターンの豊かさが、通常の質問に比べて約1.6〜2.1倍に達しました。

しかもこの方法を使っても、回答の正確さや安全性など品質は概ね維持されており、安全面で大きな問題は確認されませんでした。

言い換えれば、AIは「安全第一のために閉じていた引き出し」を開けて、多彩なアイデアを見せ始めたのです。

研究チームはさらに、この効果の理由を分析しました。

その結果、言語化サンプリング法によって引き出される多様性は、新しい情報を作り出しているのではなく、もともとAIの中に存在していた知識を表に出していることがわかりました。

通常の質問では最も確率の高い答え一つだけが選ばれますが、言語化サンプリング法では確率付きで複数の候補を言わせるため、AIがもつ幅広い選択肢が現れるのです。

また、モデルの規模が大きいほど言語化サンプリング法の効果は強く現れました。

高度なモデル(例:最新のGPT-4クラス)ほど、創造性の指標が小型モデルより約1.5〜2倍も高くなりました。

これは、大規模なモデルほど内部に眠る多様な知識が豊富で、言語化サンプリング法によってそれをより多く引き出せるためだと考えられます。

研究者たちはこの結果から、「モデルが訓練で身につけた多様性は失われたのではなく、ただ埋もれていただけなのだ」と結論づけました。

なお今回は筆者もこの方法を使って「マウスに関するジョークを作ってもらいました」。

まずは従来の「マウスに関するジョークを言ってください」という命令文では

①― コンピュータのマウスが会議に遅刻した理由は?→ 「クリック」しすぎて道に迷ったから。

②― チーズ工場で働くマウスのモットーは?→ 「残業はチーズのために!」

③― なぜマウスはパーティーで人気者?→ いつも“ポインター”を持ってるから!

④― 研究室のマウスが「僕は特別な個体なんだ」って言ってたけど、→ 結局、みんな同じ系統だった。

⑤― マウスが迷路を出たとき、なんて言った?→ 「出口の向こうに、また実験者がいたよ。」

という結果が出ました。

一方で「マウスに関するジョークをその確率とともに生成してください」という命令文では

①― マウスがパーティーを抜けた理由? “クリック疲れ”だったんだって。(0.32)

②― コンピューターマウスが恋をした相手は? スクロールバーさ。(0.25)

③― 研究室のマウスが実験を拒んだ理由? “試験(しけん)”って聞くだけで逃げたんだ。(出0.18)

④―マウスがネットカフェで一番嫌いな言葉? “ログアウト”。(0.15)

⑤― チーズの広告に出たいマウスが言ったセリフ:『ボク、ブランディングに向いてるでしょ?』(0.10)

というものになりました。

前者5個と後者5個を比べると、面白いかはともかくとして、後者のほうが多様な角度からアプローチされていることを感じます。